En la era digital, las empresas generan una cantidad inimaginable de datos. Estos datos, conocidos como Big Data, representan una oportunidad única para obtener insights valiosos y tomar decisiones estratégicas. Sin embargo, para aprovechar todo el potencial del Big Data, es necesario contar con las herramientas adecuadas.

Mejores Herramientas de Big Data para Análisis de Datos

En la era digital, el análisis de grandes volúmenes de datos se ha convertido en una pieza fundamental para el éxito de las empresas. El término Big Data se refiere al manejo y análisis de conjuntos de datos tan grandes y complejos que requieren herramientas especializadas para procesarlos. Estas herramientas permiten a las organizaciones extraer información valiosa, tomar decisiones informadas y obtener ventajas competitivas.

¿Qué es el Big Data?

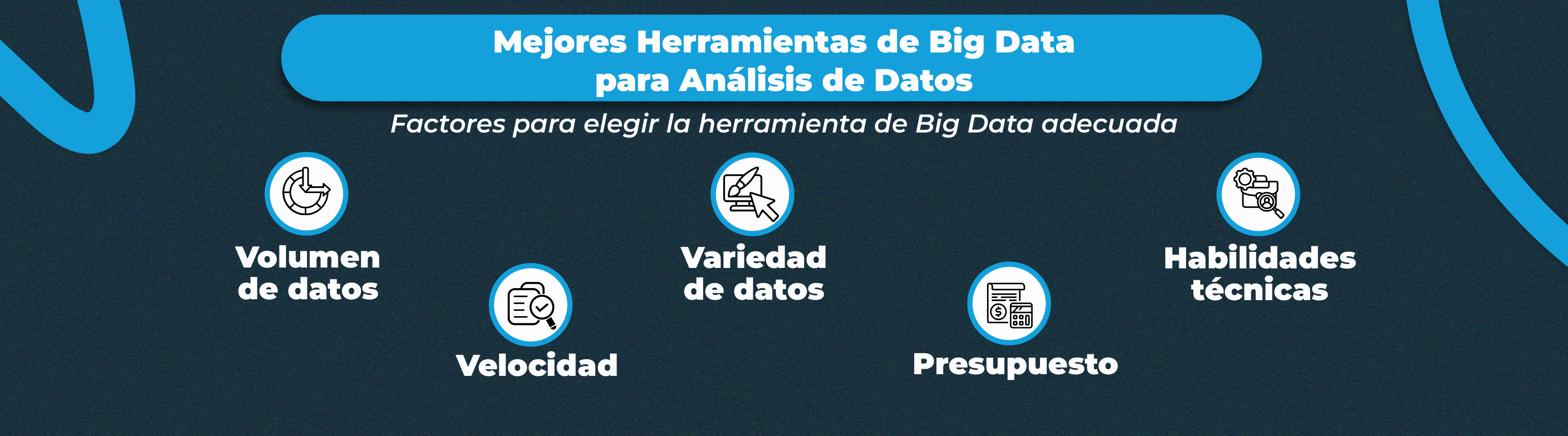

Antes de profundizar en las herramientas, es esencial entender qué es el Big Data. El término se refiere a conjuntos de datos que son tan grandes, variados y de alta velocidad que no pueden ser procesados de manera efectiva con herramientas tradicionales de gestión de datos. El Big Data se caracteriza por las tres V:

Volumen: La cantidad de datos es enorme, desde terabytes hasta petabytes o más.

Velocidad: La rapidez con la que se generan y procesan los datos es alta.

Variedad: Los datos provienen de diferentes fuentes y pueden ser estructurados (como bases de datos), semiestructurados (como archivos XML o JSON) o no estructurados (como videos, imágenes y texto).

Para manejar estos desafíos, se necesitan herramientas avanzadas que permitan el almacenamiento, procesamiento y análisis eficaz de los datos. A continuación, revisaremos algunas de las mejores herramientas de Big Data disponibles.

1. Apache Hadoop

Apache Hadoop es una de las herramientas más populares y ampliamente utilizadas para el manejo de Big Data. Es un marco de trabajo de código abierto que permite el procesamiento distribuido de grandes conjuntos de datos en clústeres de computadoras utilizando un modelo de programación simple. Hadoop se compone de varios componentes:

- Hadoop Distributed File System (HDFS): Sistema de archivos distribuido que permite el almacenamiento de grandes volúmenes de datos.

- MapReduce: Modelo de procesamiento que divide los datos en bloques y los procesa en paralelo para aumentar la eficiencia.

- YARN: Sistema de gestión de recursos que permite a diferentes aplicaciones acceder a los recursos del clúster.

- HBase: Base de datos NoSQL que proporciona almacenamiento distribuido y escalable.

Ventajas de Apache Hadoop:

- Escalabilidad: Puede manejar petabytes de datos distribuidos en miles de nodos.

- Resistencia a fallos: Si un nodo falla, los datos se replican automáticamente para evitar la pérdida.

- Flexibilidad: Admite diferentes tipos de datos, tanto estructurados como no estructurados.

Uso Típico: Procesamiento de grandes volúmenes de datos para análisis en industrias como telecomunicaciones, finanzas y comercio electrónico.

2. Apache Spark

Apache Spark es otra herramienta de código abierto que ha ganado popularidad por su capacidad para procesar datos de forma rápida y eficiente. A diferencia de Hadoop, Spark utiliza un motor de procesamiento en memoria, lo que permite ejecutar tareas de análisis de datos hasta 100 veces más rápido. Spark es ideal para aplicaciones que requieren análisis en tiempo real, como transmisiones de datos y aprendizaje automático.

Características Principales de Apache Spark:

- Procesamiento en Memoria: Reduce el tiempo de procesamiento al mantener los datos en la memoria en lugar de escribirlos en disco.

- Soporte para Múltiples Lenguajes: Spark admite Java, Scala, Python y R, lo que facilita su uso por desarrolladores y científicos de datos.

- Bibliotecas Integradas: Spark incluye bibliotecas para SQL, streaming, machine learning y gráficos, lo que facilita el desarrollo de aplicaciones complejas.

Ventajas de Apache Spark:

- Alta velocidad de procesamiento.

- Fácil integración con otras herramientas de Big Data, como Hadoop y Kafka.

- Escalabilidad para manejar grandes volúmenes de datos.

Uso Típico: Análisis en tiempo real, machine learning y procesamiento de datos de streaming.

3. Apache Kafka

Apache Kafka es una plataforma de transmisión de datos distribuida y de código abierto, diseñada para manejar flujos de datos en tiempo real. Kafka permite a las organizaciones procesar y analizar datos a medida que se generan, lo que es ideal para aplicaciones que requieren respuestas rápidas, como análisis de redes sociales, monitoreo de fraudes y sistemas de recomendación.

Características Principales de Apache Kafka:

- Publicación y Suscripción de Datos: Permite la transmisión de datos en tiempo real mediante un modelo de publicación/suscripción.

- Alta Durabilidad y Fiabilidad: Los datos se almacenan en disco, lo que garantiza su durabilidad.

- Escalabilidad: Kafka puede manejar grandes volúmenes de datos distribuidos en múltiples servidores.

Ventajas de Apache Kafka:

- Procesamiento de datos en tiempo real.

- Alta fiabilidad y resistencia a fallos.

- Fácil integración con otras herramientas de análisis, como Apache Spark y Hadoop.

Uso Típico: Análisis de datos en tiempo real, monitoreo de sistemas y análisis de comportamiento del cliente.

4. Tableau

Tableau es una herramienta de visualización de datos que permite a los usuarios crear gráficos interactivos y paneles de control para analizar grandes conjuntos de datos. Aunque no es una herramienta específica para el manejo de Big Data, Tableau se integra fácilmente con plataformas de Big Data como Hadoop y Spark, lo que permite a los usuarios visualizar y analizar datos complejos de manera intuitiva.

Características Principales de Tableau:

- Interfaz Intuitiva: Permite a los usuarios arrastrar y soltar datos para crear visualizaciones sin necesidad de programación.

- Conexión a Múltiples Fuentes de Datos: Tableau puede conectarse a bases de datos, hojas de cálculo y plataformas de Big Data.

- Visualizaciones Interactivas: Los usuarios pueden explorar los datos mediante gráficos dinámicos y paneles de control.

Ventajas de Tableau:

- Fácil de usar, incluso para usuarios no técnicos.

- Permite crear visualizaciones detalladas y atractivas.

- Integra análisis de datos avanzados.

Uso Típico: Análisis de ventas, inteligencia de negocios y visualización de datos de grandes conjuntos.

5. Microsoft Power BI

Microsoft Power BI es otra herramienta popular para la visualización y análisis de datos. Ofrece una interfaz fácil de usar y se integra con otras soluciones de Microsoft, como Azure y SQL Server, lo que la hace ideal para empresas que ya utilizan productos de Microsoft.

Características Principales de Power BI:

- Integración con Múltiples Fuentes de Datos: Permite conectar datos desde Excel, SQL Server, Azure y otros servicios en la nube.

- Análisis Avanzado: Ofrece análisis predictivos y de machine learning integrados.

- Visualizaciones Personalizadas: Los usuarios pueden crear gráficos y paneles de control personalizados.

Ventajas de Power BI:

- Fácil de integrar con otras herramientas de Microsoft.

- Interfaz amigable para usuarios no técnicos.

- Capacidad para manejar grandes volúmenes de datos.

Uso Típico: Reportes de ventas, análisis de rendimiento y creación de paneles de control para inteligencia de negocios.

El análisis de datos de Big Data requiere herramientas avanzadas que puedan manejar grandes volúmenes de datos y proporcionar información valiosa en tiempo real. Herramientas como Apache Hadoop, Apache Spark, Apache Kafka, Tableau y Microsoft Power BI ofrecen soluciones poderosas para diferentes necesidades de análisis de datos. La elección de la herramienta adecuada dependerá del tipo de datos que manejes, tus objetivos de análisis y las capacidades técnicas de tu equipo.

Déjanos tu comentario

Tu opinión nos ayuda a esforzarnos más para hacer programas con altos estándares de calidad que te ayuden a mejorar profesionalmente.